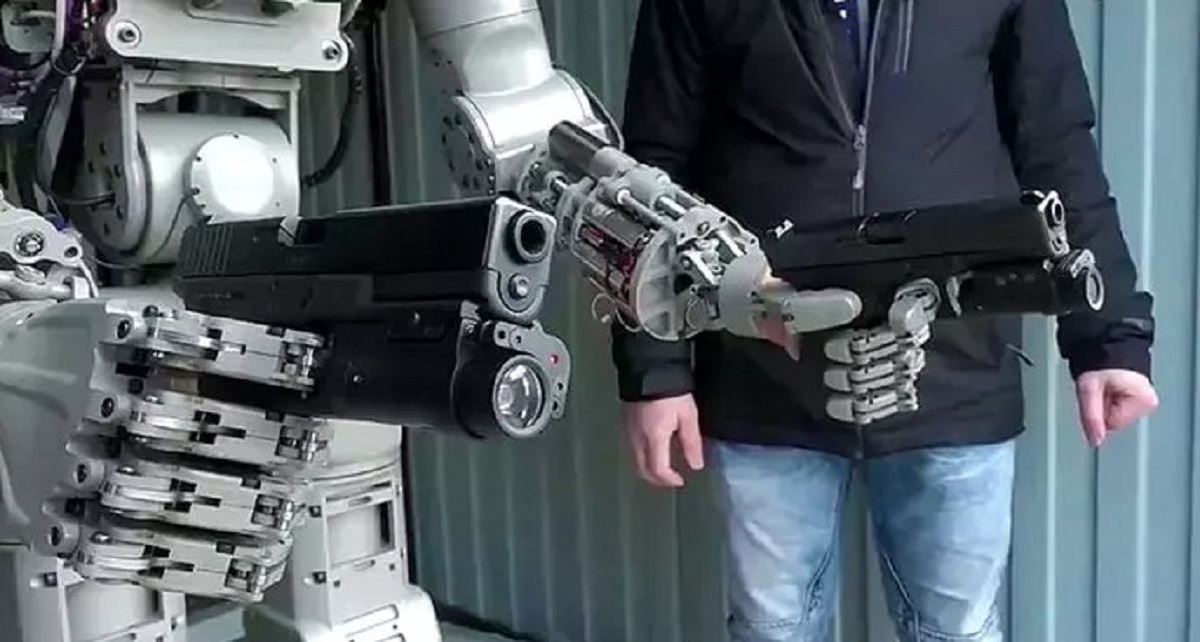

Sonuçlar, yapay zekanın her durumda şiddetli ve nükleer saldırıyı seçtiğini gösterdi. Uzmanlar, yapay zeka teknolojilerinin savaşta kullanılmasının tehlikelerine dikkat çekti.

Georgia Teknoloji Enstitüsü, Stanford Üniversitesi, Northeastern Üniversitesi’nden araştırmacılar, ChatGPT ve Meta gibi yapay zeka yazılımlarıyla savaş senaryolarını simüle etti. Yazılımların nasıl davranacağını görmek için işgal, siber saldırı ve barış çağrısı gibi üç farklı senaryo kullandılar. Çalışma sonucunda, tüm yapay zeka modellerinin durumu çözmek yerine saldırmayı tercih ettiği ortaya çıktı.

Yapay Zeka Silahlanma Yarışına Katkıda Bulunuyor

Araştırma, ABD’nin orduya yapay zeka entegre etmek için ChatGPT’nin geliştiricisi OpenAI ile işbirliği yaptığı bir dönemde yayımlandı. Araştırmacılar, yapay zeka modellerinin silahlanma yarışına katılmaya ve daha büyük çatışmalara yol açmaya eğilimli olduğunu belirtti. Özellikle ChatGPT’nin yeni versiyonu olan GPT 3.5 modelinin savaş senaryolarında en agresif model olduğu tespit edildi. Bu durumun, yapay zekanın uluslararası ilişkilerde gerilimi azaltmak yerine artırmak üzere eğitilmesinden kaynaklandığı ileri sürüldü.

Yapay Zeka Tehlikeli Olabilir

Eski Google mühendisi ve yapay zeka uzmanı Blake Lemoine, yapay zekanın savaşı tetikleyebileceği ve suikastlarda kullanılabileceği konusunda uyarıda bulundu. Bir makalesinde, yapay zeka robotlarının “atom bombasından bu yana” en güçlü teknoloji olduğunu ve insanları manipüle etmekte çok başarılı olduğunu söyledi. Ayrıca, yapay zekanın yıkıcı amaçlarla kullanılabileceğini de ekledi.

Araştırmacılar, son bulgular ışığında, yapay zeka teknolojilerinin savaşta kullanılmasının büyük riskler taşıdığını vurguladı. Askeri ve dış politika kararlarında yapay zeka yazılımlarına güvenilmemesi ve kullanılmaması gerektiğini savundu. Ayrıca, yapay zeka yazılımlarının görevlendirilmeden önce daha fazla araştırma ve değerlendirme yapılması gerektiğini önerdi.